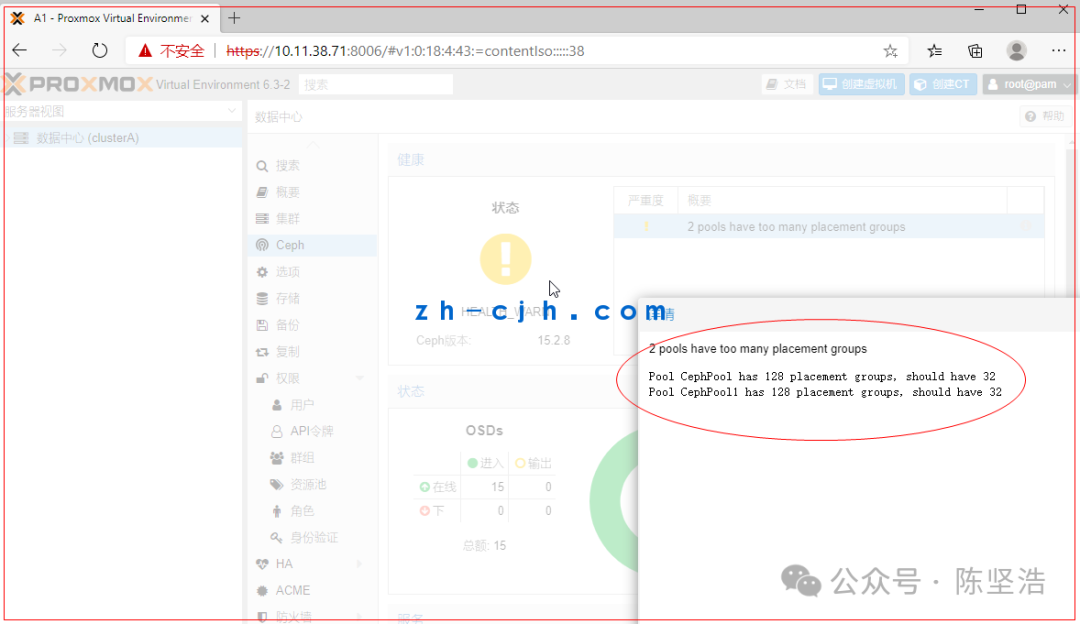

ProxmoxVE6.3(超融合):系统健康警告:Pool CephPool1 has 128 placement groups, should have 32

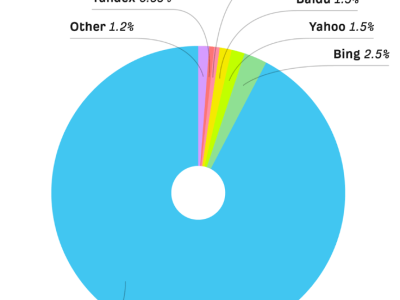

如何使用ProxmoxVE超融合(ProxmoxVE超融合采用Ceph),要把Ceph学好,包括工作原理等,开源的东西嘛,考验的就是你的学习能力。后面找时间把Ceph专门给学习下,现在搞点ProxmoxVE超融合的的皮毛,包括ProxmoxVE的网络规划等。

可参考:https://pve.proxmox.com/wiki/Deploy_Hyper-Converged_Ceph_Cluster

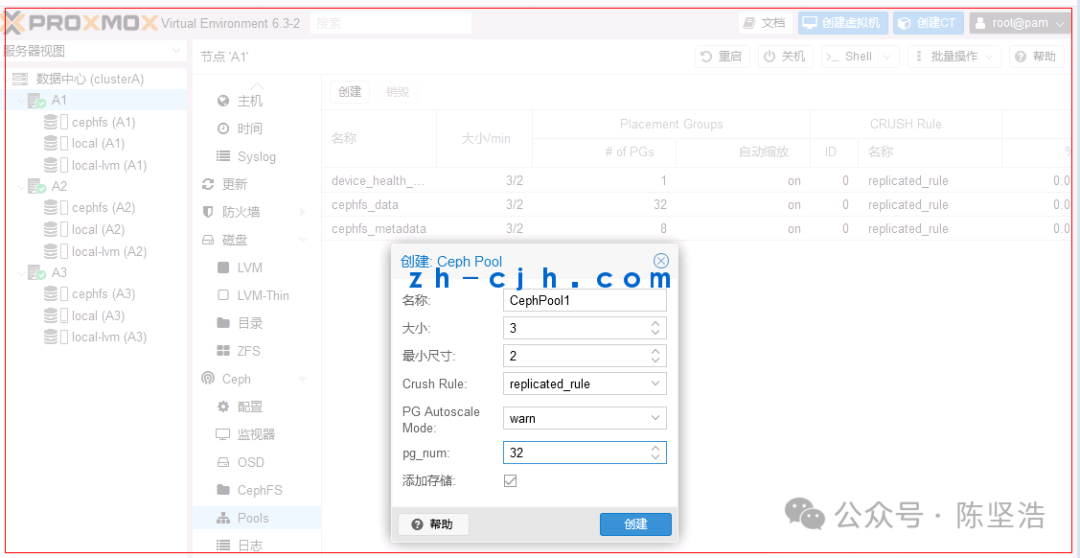

出现此警告,可以在创建Ceph FS和CephPool时选择32。

警告信息如下:

解决:

可在在创建CephFS和CephPool时修改Placement Groups为32

扩展:

Ceph Pool操作总结一个ceph集群可以有多个pool,每个pool是逻辑上的隔离单位,不同的pool可以有完全不一样的数据处理方式,比如Replica Size(副本数)、Placement Groups、CRUSH Rules、快照、所属者等。

Ceph 客户端向 monitor 请求集群的状态,并向 Pool 中写入数据,数据根据 PGs 的数量,通过

CRUSH 算法将其映射到不同的 OSD 节点上,实现数据的存储。

ceph Placement Groups

在Ceph中,放置组(Placement Groups, PGs)是分布式存储系统中用于管理和存储数据的关键概念。每个PG负责一定量的数据,并通过将这些数据分散在多个OSD(对象存储守护进程)上来实现数据的冗余和可靠性。

PG组的大小

PG组的大小通常指的是一个PG中包含的物理存储对象(Object)的数量。这个数量直接影响着数据的分布和访问效率。

注意事项

性能与冗余:增加PG数量可以提高系统的并发性能,因为它允许更多的并发读写操作。然而,过多的PG数量可能会降低系统的整体性能,因为它会分散更多的负载到更多的OSD上。

数据分布:PG的数量也影响着数据的分布。过多的PG可能导致某些OSD过载,而过少的PG可能导致数据分布不均。通常建议根据集群的规模和性能需求来调整PG数量。

副本数与CRUSH映射:PG的大小还应与副本数(副本数通常设置为3)结合考虑。例如,如果你设置了64个PGs和3个副本,那么每个PG将会有9个对象(3个副本分布在不同的OSD上)。

自动调整:在某些版本的Ceph中,可以通过设置target_size_ratio和target_max_objects来让Ceph自动调整PG的大小以优化性能和负载均衡。例如:

ceph osd pool set mypool target_size_ratio 0.8

ceph osd pool set mypool target_max_objects 100000

ceph Placement Groups设置的数量大小的区别:

Ceph 中的 PG(Placement Groups,归置组)数量设置的大小直接影响集群性能、数据分布均衡性和资源开销,主要区别如下:

一、PG 数量设置较大的优缺点

1、优点

数据分布更均衡:PG 数量多意味着每个 PG 管理的对象更少,数据能更均匀地分散到所有 OSD 上,减少热点 OSD 出现概率。

并行度提升:读写操作可在更多 PG 上并行执行,尤其在大规模集群中能提升 IOPS 和吞吐量。

扩容友好:新增 OSD 后,数据再平衡(Rebalancing)速度更快,因需迁移的数据粒度更细。

2、缺点

资源消耗增加:

MON 需维护更多 PG 状态元数据,内存占用显著上升;

OSD 需处理更多 PG 的心跳检测、状态同步等开销。

恢复效率降低:单个 OSD 故障时,需恢复的数据分散在更多 PG 中,重建过程可能更慢(需权衡并行度)。

二、PG 数量设置较小的优缺点

优点

资源开销低:减少 MON 和 OSD 的元数据管理压力,节省内存与 CPU。

恢复速度快:单 OSD 故障时,需迁移的数据集中在较少 PG 内,重建耗时较短。

缺点

数据分布不均衡风险:

少量 PG 导致单个 PG 管理的对象过多,易引发 OSD 负载不均;

新 OSD 加入后,数据再平衡效率低,可能出现性能瓶颈。

并行度受限:高并发场景下,较少的 PG 可能限制 IO 并行处理能力。

三、优化建议

计算公式:

PG 总数 ≈ (OSD 总数 × 100) / 副本数(如 10 OSD、副本数 3,则 PG 总数 ≈ 333)。

调整原则:

优先选择接近 2 的幂次的值(如 256、512)以优化 CRUSH 计算效率;

单池 PG 数(pg_num)与归置组(pgp_num)需保持一致。

四、关键影响总结

错误配置示例:若 PG 过少导致单 OSD 承载 PG 数 > 100,可能触发 mon_max_pool_pg_num 告警。

本文完。

本文链接:https://www.kinber.cn/post/5367.html 转载需授权!

推荐本站淘宝优惠价购买喜欢的宝贝:

支付宝微信扫一扫,打赏作者吧~

支付宝微信扫一扫,打赏作者吧~